AI Act: la UE Aprueba el Primer Reglamento del Mundo sobre Inteligencia Artificial

El AI Act representa un paso fundamental hacia la regulación de esta tecnología, contribuyendo a crear un entorno digital más seguro y ético para todos.

Desde la industria manufacturera hasta la atención sanitaria, desde la movilidad hasta las finanzas, la IA se ha consolidado como una fuerza impulsora de la transformación digital. La automatización de procesos complejos, el análisis de grandes volúmenes de datos y la optimización de sistemas preexistentes son solo algunos ejemplos de su impacto disruptivo.

Esta rápida evolución ha hecho que la regulación de esta tecnología sea cada vez más necesaria y urgente, ya que, por su naturaleza (es decir, su capacidad de tomar decisiones y de autoaprendizaje), conlleva importantes y delicadas implicaciones éticas.

Desde abril de 2021, la UE ha estado trabajando en el llamado AI Act, el primer marco normativo armonizado sobre inteligencia artificial, que fue aprobado por el Parlamento Europeo el 13 de marzo de 2024. El 1 de agosto de 2024, el AI Act entró en vigor.

El AI Act se basa en el principio de que la IA debe desarrollarse y utilizarse de manera segura, ética y respetuosa con los derechos fundamentales y los valores europeos, garantizando el control humano, la seguridad, la privacidad, la transparencia, la no discriminación y el bienestar social y medioambiental. De hecho, las aplicaciones de IA están alcanzando una capacidad de análisis cada vez mayor y pueden «decidir» qué acciones tomar en función de los datos disponibles. Pero si una aplicación de IA toma una decisión incorrecta o que favorece injustamente o perjudica a un ser humano, ¿quién será responsable? Es por eso que, con la expansión de esta tecnología, la UE ha decidido trabajar en lo que es el primer reglamento sobre IA en el mundo.

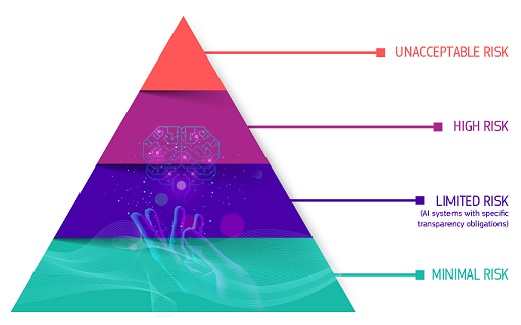

Un enfoque basado en el riesgo

La inteligencia artificial puede transformar profundamente la sociedad y la economía, pero al mismo tiempo también puede presentar riesgos para los derechos, la seguridad y el buen funcionamiento del mercado único. Para encontrar un equilibrio entre ambas cuestiones, es decir, acompañar a Europa en la adopción de la IA y de sus beneficios, y hacerlo en pro del interés general, el AI Act se ha concebido con un enfoque basado en el riesgo.

El marco regulatorio sobre IA prevé una clasificación de los sistemas de IA según el nivel de riesgo que representan para las personas y para la sociedad, y establece una serie de requisitos y obligaciones para los proveedores y usuarios de dichos sistemas. El marco distingue entre cuatro categorías de riesgo: inaceptable, alto, limitado y mínimo.

Riesgo inaceptable

Los sistemas de IA que presentan un riesgo inaceptable son aquellos que contradicen los valores y principios fundamentales de la UE, como el respeto a la dignidad humana, la democracia y el estado de derecho. Estos sistemas están prohibidos o sujetos a severas restricciones. En concreto, están prohibidos los sistemas de categorización biométrica basados en características sensibles y la extracción indiscriminada de imágenes faciales de Internet o de grabaciones de sistemas de cámaras de circuito cerrado para crear bases de datos de reconocimiento facial. También están prohibidos los sistemas de reconocimiento de emociones en el lugar de trabajo y en las escuelas, los sistemas de scoring social, las prácticas de policía predictiva (si se basan únicamente en la elaboración de perfiles o en la evaluación de las características de una persona) y los sistemas que manipulan el comportamiento humano o explotan las vulnerabilidades de las personas, como por ejemplo los juguetes que utilizan asistencia por voz para fomentar comportamientos peligrosos.

Riesgo alto

Los sistemas de IA que presentan un riesgo alto son aquellos que pueden tener un impacto “sistémico”, es decir, significativo en los derechos fundamentales o en la seguridad de las personas. En esta categoría se incluyen los sistemas de IA utilizados para la selección y reclutamiento de personal, para la admisión en la educación, para la prestación de servicios sociales esenciales, como la sanidad, para la vigilancia biométrica a distancia (no en tiempo real), para aplicaciones judiciales y policiales, o para la gestión de la seguridad crítica de infraestructuras.

Estos sistemas están sujetos a estrictos requisitos y obligaciones antes de poder ser introducidos en el mercado o utilizados, salvo algunas excepciones rigurosamente definidas y reguladas, como cuando son necesarios para la búsqueda de un menor desaparecido, para prevenir una amenaza terrorista específica e inminente o para identificar, localizar o procesar a un autor o sospechoso de un delito grave. Dichos usos están sujetos a la autorización de un órgano judicial o de otro órgano independiente y a límites de tiempo, alcance geográfico y búsqueda en bases de datos.

Riesgo limitado

Los sistemas de IA que presentan un riesgo limitado son aquellos que pueden influir en los derechos o la voluntad de los usuarios, pero en menor medida que los sistemas de alto riesgo. Por ejemplo, en esta categoría se incluyen los sistemas de IA utilizados para generar o manipular contenidos audiovisuales (como los deepfakes) o para ofrecer sugerencias personalizadas (como los chatbots). Estos sistemas están sujetos a requisitos de transparencia, que permiten a los usuarios ser conscientes de que están interactuando con un sistema de IA y comprender sus características y limitaciones. Por ejemplo, un individuo que interactúa con un chatbot debe ser informado de que está interactuando con una máquina, para que pueda decidir si continuar o solicitar hablar con un ser humano.

Riesgo mínimo

Los sistemas de IA que presentan un riesgo mínimo o nulo son aquellos que no tienen ningún impacto directo en los derechos fundamentales o en la seguridad de las personas, y que ofrecen amplios márgenes de elección y control a los usuarios. Estos sistemas están libres de cualquier obligación normativa, con el fin de fomentar la innovación y la experimentación. Por ejemplo, en esta categoría se incluyen los sistemas de IA utilizados con fines recreativos (como los videojuegos) o con fines puramente estéticos (como los filtros fotográficos).

Sanciones

El AI Act prevé un sistema de sanciones en caso de violación de las disposiciones previstas. Las sanciones pueden variar según la gravedad y la naturaleza de la infracción, y son proporcionales al tamaño y la facturación del operador económico responsable. Las sanciones pueden incluir:

- advertencias o apercibimientos por parte de las autoridades nacionales competentes, con la posibilidad de adoptar medidas correctivas;

- multas de hasta 35 millones de euros o el 7% de la facturación anual total mundial del ejercicio financiero anterior (según cuál sea el valor más alto) por violaciones relacionadas con prácticas prohibidas o el incumplimiento de los requisitos sobre datos;

- multas de hasta 15 millones de euros o el 3% de la facturación anual total mundial del ejercicio financiero anterior por el incumplimiento de cualquiera de los demás requisitos u obligaciones del reglamento, incluida la violación de las normas sobre modelos de IA de uso general;

- multas de hasta 7,5 millones de euros o el 1,5% de la facturación anual total mundial del ejercicio anterior por proporcionar información inexacta, incompleta o engañosa a los organismos notificados y a las autoridades nacionales competentes en respuesta a una solicitud.

La regulación de las aplicaciones de inteligencia artificial representa un paso fundamental hacia un uso responsable y seguro de esta poderosa tecnología, para moldear un futuro en el que la inteligencia artificial sea un aliado confiable y respetuoso con los valores humanos, contribuyendo a crear un entorno digital más seguro y ético para todos. La clave radica en el equilibrio entre la innovación tecnológica y la protección de los derechos humanos, un objetivo que requiere un compromiso constante por parte de todos los actores involucrados.

Fuente: por la Redacción de Exportamos, info@exportamos.info